15 mei Zo bereken je testscores in Comproved

De comparing-tool van Comproved werkt volgens de methode van comparatief beoordelen. Hierbij krijgen beoordelaars telkens twee producten aangeboden waarbij ze moeten aanduiden welk product zij het betere vinden. Op basis van al die keuzes van de verschillende beoordelaars plaatst de tool de producten op een rangorde. Die rangorde kan uiteindelijk omgezet worden in testscores. Hoe dat precies in z’n werk gaat, leggen we uit in dit artikel.

Tijdens een assessment biedt de comparing-tool elk product meerdere keren in verschillende paren aan verschillende beoordelaars aan. Zij kiezen telkens wat volgens hen, in het licht van de te beoordelen competentie, het beste product in het paar is. Dat levert heel wat data op waarop de tool een Rasch-analyse uitvoert, meer bepaald volgens het Bradley-Terry-Luce model. Deze analyse levert kwaliteitsscores op. Die scores vind je in de tool onder ability en gaan vaak van -3 tot +3. Die abilities drukken een kans uit dat het product zou ‘winnen’ in een vergelijking met een product met een ability-waarde van 0. Zo heeft een product met een ability van 2 meer dan 90% kans om te winnen in een vergelijking met een product met een ability van 0. Aan de hand van deze kwaliteitsscores vormt de tool de rangorde. Comproved biedt de mogelijkheid aan om deze kwaliteitsscores om te zetten in een cijfer. Zo’n cijfer noemen we dan een testscore.

Waarom testscores in Comproved?

Wanneer een assessment afgelopen is, zijn de kwaliteitsscores van de producten betrouwbaar geschat. De kwaliteitsscores op zichzelf zijn echter moeilijk te interpreteren en te rapporteren. Ze zijn immers niet relatief ten opzichte van een maximumscore of norm. Het is dan ook niet mogelijk om de kwaliteitsscores van een assessment te vergelijken met een ander assessment. Bijvoorbeeld, een product A met een kwaliteitsscore van 1,5 in een assessment X kan resulteren in een testscore van 6/10, terwijl eenzelfde kwaliteitsscore van 1,5 voor een product B in een assessment Y kan resulteren in een testscore van 8/10.

Hoe bepaal je testscores?

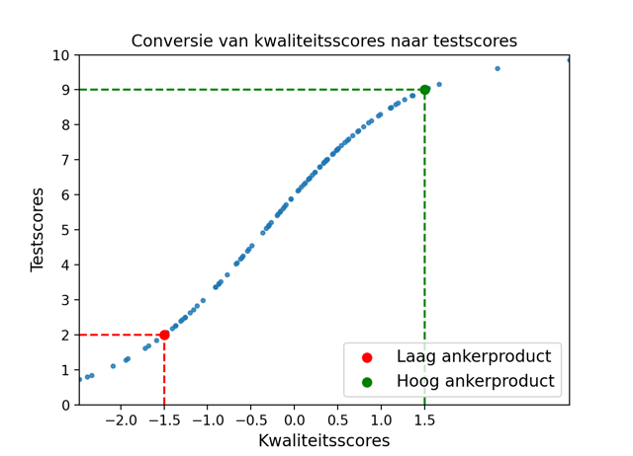

Een illustratie: Voor een assessment X wil een docent een cijfer op 10 bepalen. De kwaliteitsscores van het assessment moeten dan omgezet worden naar testscores op een schaal van 0 tot 10. Hiervoor zal de docent na afloop van het assessment, wanneer alle vergelijkingen gemaakt zijn, twee ankerpunten selecteren. Een vuistregel om die ankerpunten te bepalen, is om een product op 1/3 van de rangorde (hoge kwaliteit) en een product op 2/3 van de rangorde (lage kwaliteit) te selecteren en ervoor te zorgen dat de kwaliteitsscores onderling ongeveer 2 abilities verschillen (bv. een product met ability 1,59 als hoog en een product met ability -1,08 als laag). Aan deze ankerpunten dient in consensus een cijfer of testscore te worden toegekend.

In het voorbeeld besloten de assessoren in overleg dat het ankerproduct met een kwaliteitsscore van -1,5 een testscore van 2/10 krijgt. Het ankerproduct met een kwaliteitsscore van 1,5 krijgt een testscore van 9/10. Op basis van de toegekende testscores voor de ankerproducten, kan de tool vervolgens de testscores van alle andere producten afleiden. De onderstaande figuur toont hoe de kwaliteitsscores getransformeerd worden naar de testscores op een schaal van 0 tot 10. Hiervoor baseren we ons op de methode van Fair Averages zoals voorgesteld door Linacre.

Let op hoe de testscores niet-proportioneel (geen lineair verband) zijn met de kwaliteitsscores. Bijvoorbeeld, wanneer de kwaliteitsscore stijgt van 0 naar 1,5 dan stijgt de testscore ongeveer 3 punten. Maar wanneer de kwaliteitsscore stijgt van -1,5 naar 0 dan stijgt de testscore ongeveer 4 punten. We kunnen garanderen dat de testscores nauwkeurig zijn zolang de gegeven testscores voor de ankerproducten correct zijn. Comproved adviseert dat assessoren in overleg de testscores van de ankerproducten vastleggen.

Kan je rangordes van verschillende assessments vergelijken aan de hand van de testscores?

Het is mogelijk om de testscores van verschillende assessments te combineren door de testscores te kalibreren. Dit is enkel mogelijk wanneer de opdracht in de assessments hetzelfde is. Dat wil zeggen wanneer eenzelfde competentie wordt beoordeeld, de betrouwbaarheid van de afzonderlijke rangordes hoog genoeg is (>.70) én er ankerpunten worden meegenomen.

Een voorbeeld: In een assessment A wordt een competentie X beoordeeld. In een assessment B wordt dezelfde competentie X beoordeeld. Assessment B zou bijvoorbeeld een nieuw meetmoment op een later tijdstip bij dezelfde studenten kunnen zijn, of een assessment in een andere klas. Deze twee rangordes zou je nu aan elkaar kunnen koppelen. Hiervoor neem je twee ankerpunten uit assessment A mee in assessment B. Assessment B bestaat dan uit alle studenten van assessment B + de twee ankerpunten uit assessment A.

Vervolgens bepaal je in assessment A de testscores. Op die manier krijgen ook de ankerpunten een testscore. Bij het bepalen van de testscores in assessment B geef je de ankerpunten dezelfde scores als in assessment A. Op die manier wordt de norm van assessment A overgezet op assessment B en kan je de rangordes vergelijken op basis van testscores. Je zou de rangordes ook kunnen samenvoegen tot één rangorde op basis van die testscores.